Hidden Markov Model

DasHidden Markov Model,kurzHMM(deutschverdecktes Markowmodell,oderverborgenes Markowmodell) ist einstochastischesModell,in dem ein System durch eineMarkowkette– benannt nach dem russischen MathematikerA. A. Markow– mit unbeobachteten Zuständen modelliert wird. Ein HMM kann dadurch als einfachster Spezialfall einesdynamischen bayesschen Netzesangesehen werden.

Die Modellierung als Markowkette bedeutet, dass das System auf zufällige Weise von einem Zustand in einen anderen übergeht, wobei dieÜbergangswahrscheinlichkeitennur jeweils vom aktuellen Zustand abhängen, aber nicht von den davor eingenommenen Zuständen. Außerdem wird angenommen, dass die Übergangswahrscheinlichkeiten über die Zeit konstant sind. Bei einem HMM werden jedoch nicht die Zustände selbst von außen beobachtet; sie sindverborgen(engl.hidden,siehe auchLatentes Variablenmodell). Stattdessen sind jedem dieser inneren Zustände beobachtbare Ausgabesymbole (sogenannteEmissionen) zugeordnet, die je nach Zustand mit gewissen Wahrscheinlichkeiten auftreten. Die Aufgabe besteht meist darin, aus der beobachteten Sequenz der Emissionen zuwahrscheinlichkeitstheoretischenAussagen über die verborgenen Zustände zu kommen.

Da die Markowmodelle eng verwandt mit den in der Regelungstechnik verwendeten Zustandsraummodellen sind, ist darauf zu achten, dass der Begriff „beobachten “nicht mit dem regelungstechnischen Begriff der „Beobachtbarkeit“,der vonRudolf Kálmán1960 eingeführt wurde und eine eigenständige Systemeigenschaft beschreibt, verwechselt wird. „Beobachten “im Sinn der Markowmodelle wird in der Regelungstechnik mit „messen “bezeichnet. Die im Sinn der Markowtheorie „unbeobachteten “oder „hidden “Zustände können sehr wohl im Sinne der Regelungstechnik beobachtbar sein, müssen es aber nicht.

Wichtige Anwendungsgebiete sindSprach-undSchrifterkennung,ComputerlinguistikundBioinformatik,Spamfilter,Gestenerkennungin derMensch-Maschine-Kommunikation,physikalische Chemie[1]undPsychologie.

Markowansatz

[Bearbeiten|Quelltext bearbeiten]Gegeben seien zweizeitdiskrete Zufallsprozesseund,von denen nur der letzte beobachtbar sei. Durch ihn sollen Rückschlüsse auf den Verlauf des ersten Prozesses gezogen werden; hierfür wird ein mathematisches Modell benötigt, das die beiden Prozesse miteinander in Beziehung setzt.

Der hier beschriebene Ansatz zeichnet sich durch die folgenden beiden Annahmen aus:

- 1. Markoweigenschaft

Der aktuelle Wert des ersten Prozesses hängt ausschließlich von seinem letzten Wert ab:

- .

- 2. Markoweigenschaft

Der aktuelle Wert des zweiten Prozesses hängt ausschließlich vom aktuellen Wert des ersten ab:

- .

Haben die beiden Prozesse nun noch jeweils einenendlichenWertevorrat, so lässt sich das so gewonnene Modell alsprobabilistischerAutomatauffassen, genauer alsMarkow-Kette. Man sagt auchist einMarkow-Prozess. Angelehnt an den Sprachgebrauch in dertheoretischen Informatik– insbesondere derAutomatentheorieund derTheorie formaler Sprachen– heißen die Werte des ersten ProzessesZuständeund die des zweitenEmissionenbzw.Ausgaben.

Definition

[Bearbeiten|Quelltext bearbeiten]

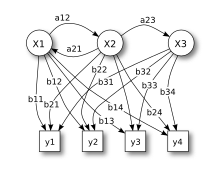

x– (verborgene) Zustände

y– mögliche Beobachtungen (Emissionen)

a– Übergangswahrscheinlichkeiten

b– Emissionswahrscheinlichkeiten

EinHidden Markov Modelist ein 5-Tupelmit:

- der Menge allerZustände,das sind die möglichen Werte derZufallsvariablen,

- dasAlphabetder möglichen Beobachtungen – dieEmissionender,

- dieÜbergangsmatrixzwischen den Zuständen,gibt dabei jeweils dieWahrscheinlichkeitan, dass vom Zustandin den Zustandgewechselt wird,

- die Beobachtungsmatrix, diegeben die Wahrscheinlichkeit an, im Zustanddie Beobachtungzu machen, sowie

- die Anfangsverteilung,ist die Wahrscheinlichkeit, dassder Startzustand ist.

Ein HMM heißestationär(oder auchzeitinvariant), wenn sich die Übergangs- und Emissionswahrscheinlichkeiten nicht mit der Zeit ändern. Diese Annahme ist oft sinnvoll, weil auch die modellierten Naturgesetze konstant sind.

Veranschaulichung

[Bearbeiten|Quelltext bearbeiten]

Das Bild zeigt die generelle Architektur eines instanziierten HMMs. Jedes Oval ist die Repräsentation einer zufälligen Variableoder,welche beliebige Werte ausbzw.annehmen kann. Die erste Zufallsvariable ist dabei der versteckte Zustand des HMMs zum Zeitpunkt,die zweite ist die Beobachtung zu diesem Zeitpunkt. Die Pfeile in demTrellis-Diagrammbedeuten einebedingte Abhängigkeit.

Im Diagramm sieht man, dass der Zustand der versteckten Variablenur vom Zustand der Variableabhängt, frühere Werte haben keinen weiteren Einfluss. Deshalb ist das Modell ein Markov-Modell 1. Ordnung. Sollten höhere Ordnungen benötigt werden, so können diese durch das Einfügen neuer versteckter Zustände stets auf die 1. Ordnung zurückgeführt werden. Der Wert vonhängt weiter ausschließlich vonab.

Beispiel

[Bearbeiten|Quelltext bearbeiten]Gefangener im Verlies

[Bearbeiten|Quelltext bearbeiten]

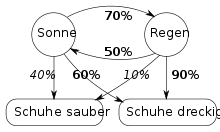

Ein Gefangener im Kerkerverlies möchte das aktuelle Wetter herausfinden. Er weiß, dass auf einen sonnigen Tag zu 70 % ein Regentag folgt und dass auf einen Regentag zu 50 % ein Sonnentag folgt. Weiß er zusätzlich, dass die Schuhe der Wärter bei Regen zu 90 % dreckig, bei sonnigem Wetter aber nur zu 60 % dreckig sind, so kann er durch Beobachtung der Wärterschuhe Rückschlüsse über das Wetter ziehen (das heißt, er kann die Wahrscheinlichkeit für Regenwetter gegenüber sonnigem Wetter abschätzen). Hier bildet das tatsächlich vorhandene, aber nicht sichtbare Wetter den zu ermittelnden versteckten Zustand, die Prozentwerte 70 % und 50 % sind (über längere Zeiten hinweg ermittelte) Trainingsdaten des Modells, und die tatsächlich beobachtbaren Zustände liegen im jeweiligen Aussehen der Schuhe.

Aus den Übergangswahrscheinlichkeitenergibt sich (langfristig, also ohne den Anfangszustand eingehen zu lassen) die Wahrscheinlichkeit für Sonne vonund für Regen von.Damit ergeben sich die Kombinationen von Zuständen mit den Wahrscheinlichkeiten:

| Sonne | Regen | |

|---|---|---|

| Saubere Schuhe | ||

| Dreckige Schuhe |

Wenn ein Wärter saubere Schuhe hat, ist die Wahrscheinlichkeit von sonnigem Wetter damitund entsprechend ist bei dreckigen Schuhen die Regenwahrscheinlichkeit etwa 67,9 %. Außerdem müssten die Wärter im Mittel zuder Tage saubere Schuhe haben, andernfalls kann sich der Gefangene überlegen, welche Parameter angepasst werden sollten, damit sein Modell stimmt.

So weit kann der Gefangene aus der Beobachtung an einem einzelnen Tag schließen. Dabei berücksichtigt er nicht die konkreten Wahrscheinlichkeiten des Wechsels von sonnigen und verregneten Tagen. Bezieht er diese mit ein, so kommt er mit demViterbi-Algorithmuszu einem etwas genaueren Ergebnis.

DNA-Sequenz: CpG-Inseln aufspüren

[Bearbeiten|Quelltext bearbeiten]Zur Untersuchung von DNA-Sequenzen mit bioinformatischen Methoden kann das HMM verwendet werden. Beispielsweise lassen sich soCpG-Inselnin einer DNA-Sequenz aufspüren. Dies sind Bereiche einesDNS-Einzelstrangs mit einem erhöhten Anteil von aufeinanderfolgendenCytosin- undGuanin-Nukleinbasen.Dabei stellt die DNS-Sequenz die Beobachtung dar, deren Zeichenbilden das Ausgabealphabet. Im einfachsten Fall besitzt das HMM zwei verborgene Zustände, nämlichCpG-Inselundnicht-CpG-Insel.Diese beiden Zustände unterscheiden sich in ihrer Ausgabeverteilung, so dass zum ZustandCpG-Inselmit größerer Wahrscheinlichkeit Zeichenundausgegeben werden.

Spracherkennung

[Bearbeiten|Quelltext bearbeiten]In der automatischen Spracherkennung mit HMM werden diegesprochenenLauteals versteckte Zustände aufgefasst und die tatsächlichhörbarenTöneals Emission.

Problemstellungen

[Bearbeiten|Quelltext bearbeiten]Im Zusammenhang mit HMMs existieren mehrere grundlegende Problemstellungen.[2][3]

Bestimmen der Modellgröße

[Bearbeiten|Quelltext bearbeiten]Gegeben sind die beobachtbaren Emissionen. Es ist zu klären, welche Modelleigenschaften – insbesondere welcheorthogonaleDimensionalität – den Schluss auf die nicht direkt beobachtbaren Zustände erlauben und gleichzeitig eine sinnvolleBerechenbarkeitzulassen. Insbesondere ist zu entscheiden, welche Laufzeit für die Modellrechnungen erforderlich werden darf, um die Verwendbarkeit der Schätzungen zu erhalten.

Implementierung

[Bearbeiten|Quelltext bearbeiten]Die Berechnung der Schätzwerte der nicht beobachtbaren Zustände aus den beobachtbaren Ausgabesequenzen muss die erreichbaren numerischen Genauigkeiten beachten. Weiter müssen Kriterien zur Klassifizierung derstatistischen Signifikanzimplementiert werden. Bei Verwendung eines HMM für einen bestimmten Merkmalsvektor bestimmt die Signifikanz die Wahrscheinlichkeit einer zutreffenden oder falschen Modellhypothese sowie derenInformationsgehalt(Entropie,bedingte Entropie) bzw. derenInformationsqualität.

Filtern

[Bearbeiten|Quelltext bearbeiten]Gegeben sei ein HMMsowie eine BeobachtungssequenzderLänge. Gesucht ist die Wahrscheinlichkeit,dass der momentane verborgene Zustand zum letzten Zeitpunktgeradeist. Ein effizientes Verfahren zur Lösung des Filterungsproblems ist derForward-Algorithmus.

Prädiktion/Vorhersage

[Bearbeiten|Quelltext bearbeiten]Gegeben sei wieder ein HMMund die Beobachtungssequenzsowie ein. Gesucht ist Wahrscheinlichkeit,also die Wahrscheinlichkeit, dass sich das HMM zum Zeitpunktim Zustandbefindet, falls die betreffende Ausgabe beobachtet wurde. Prädiktion ist dabei gewissermaßen wiederholtes Filtern ohne neue Beobachtungen und lässt sich auch einfach mit demForward-Algorithmusberechnen.

Glätten

[Bearbeiten|Quelltext bearbeiten]Erneut seien,und eingegeben. Gesucht ist die Wahrscheinlichkeit,also die Wahrscheinlichkeit, dass sich das Modell zu einem früheren Zeitpunkt in einem bestimmten Zustand befand, unter der Bedingung, dassbeobachtet wurde. Mithilfe desForward-Backward-Algorithmuskann diese Wahrscheinlichkeit effizient berechnet werden.

Dekodierung

[Bearbeiten|Quelltext bearbeiten]Seien wiedersowiegegeben. Es soll die wahrscheinlichste Zustandsfolge ausbestimmt werden, die eine vorgegebene Ausgabesequenz erzeugt haben könnte. Dieses Problem lässt sich effizient mit demViterbi-Algorithmuslösen.

Lernproblem

[Bearbeiten|Quelltext bearbeiten]Gegeben sei nur die Ausgabesequenz. Es sollen die Parameter eines HMM bestimmt werden, die am wahrscheinlichsten die Ausgabesequenz erzeugen. Dies ist lösbar mit Hilfe desBaum-Welch-Algorithmus.

Interpretationsproblem

[Bearbeiten|Quelltext bearbeiten]Gegeben seien nur die möglichen Ausgaben. Es sollen die Zustände imModellsystemund die korrespondierenden Effekte im realen System identifiziert werden, die die Zustandsmengedes Modells beschreibt.[4] Dazu muss vorweg dieBedeutsamkeitder einzelnen Emissionen bestimmt werden.

Anwendungsgebiete

[Bearbeiten|Quelltext bearbeiten]Anwendung finden HMMs häufig in derMustererkennungbei der Verarbeitung von sequentiellen Daten, beispielsweise bei physikalischenMessreihen,aufgenommenen Sprachsignalen oderProteinsequenzen.Dazu werden die Modelle so konstruiert, dass die verborgenen Zustände semantischen Einheiten entsprechen (z. B.Phonemein derSpracherkennung), die es in den sequentiellen Daten (z. B. Kurzzeit-Spektren des Sprachsignals) zu erkennen gilt. Eine weitere Anwendung besteht darin, für ein gegebenes HMM durch eine Suche in einer Stichprobe von sequentiellen Daten solche Sequenzen zu finden, die sehr wahrscheinlich von diesem HMM erzeugt sein könnten. Beispielsweise kann ein HMM, das mit Vertretern einer Proteinfamilie trainiert wurde, eingesetzt werden, um weitere Vertreter dieser Familie in großen Proteindatenbanken zu finden.

Geschichte

[Bearbeiten|Quelltext bearbeiten]Hidden-Markov-Modelle wurden erstmals vonLeonard E. Baumund anderen Autoren in der zweiten Hälfte der 1960er Jahre publiziert. Eine der ersten Applikationen war ab Mitte der 1970er die Spracherkennung. Seit Mitte der 1980er wurden HMMs für die Analyse vonNukleotid-und Proteinsequenzen eingesetzt und sind seitdem fester Bestandteil derBioinformatik.

Literatur

[Bearbeiten|Quelltext bearbeiten]- R. Merkl, S. Waack:Bioinformatik interaktiv.Wiley-VCH, 2002,ISBN 3-527-30662-5.

- G. A. Fink:Mustererkennung mit Markov-Modellen: Theorie, Praxis, Anwendungsgebiete.Teubner, 2003,ISBN 3-519-00453-4.

- Kai-Fu Lee, Hsiao-Wuen Hon:Speaker-Independent Phone Recognition Using Hidden Markov Models.IEEE Transactions on accoustics, speech and signal processing,Nr.37.IEEE, November 1989,S.1641–1648(englisch, IEEE Nr. 8930533, 0096-3518/89/1100-1641).

Weblinks

[Bearbeiten|Quelltext bearbeiten]- R.v. Handel, 28. Juli 2008:Hidden Markov Models(PDF; 900 kB; 123 Seiten) Lecture Notes Princeton University Juli 2008, abgerufen am 24. Februar 2019.

- E.G. Schukat-Talamazzini, 7. Dezember 2018:Spezielle Musteranalysesysteme(PDF; 1,3 MB; 17 Seiten) Vorlesung im WS 2018 an der Universität Jena. Kap. 5, abgerufen am 24. Februar 2019.

- HMM R-Packagezum Modellieren und Analysieren von Hidden-Markov-Modellen, das unter GPL2 frei verfügbar ist

- HMM Java-Bibliothek, die unter der neuen BSD-Lizenz verfügbar istInternal Server Error

- HMM C-Bibliothek, die unter der LGPL frei verfügbar ist

Einzelnachweise

[Bearbeiten|Quelltext bearbeiten]- ↑S. Schmid, Dissertation, Technische Universität München, München, 2017.Single Protein Dynamics at Steady State Quantified from FRET Time Traces

- ↑L. R. Rabiner:A Tutorial on Hidden Markov Models and Selected Applications in Speech Recognition.(PDF; 2,2 MB; 30 Seiten) Proceedings of the IEEE, Band 77, Nr. 2, 1989, S. 257–286.

- ↑P. Blunsom, 19. August 2004:Hidden Markov Models(PDF; 237 kB; 7 Seiten), archive.org, abgerufen am 21. Februar 2019.

- ↑S. P. Chatzis:A Variational Bayesian Methodology for Hidden Markov Models.