Indice di correlazione di Pearson

Instatistica,l'indice di correlazione di Pearson(anche dettocoefficiente di correlazione lineare[1],coefficiente di correlazione di Pearsonocoefficiente di correlazione di Bravais-Pearson) tra duevariabili statisticheè unindiceche esprime un'eventuale relazione dilinearitàtra esse.[1]

Secondo ladisuguaglianza di Cauchy-Schwarzha un valore compreso traedovecorrisponde alla perfetta correlazione lineare positiva,corrisponde a un'assenza di correlazione lineare ecorrisponde alla perfetta correlazione lineare negativa. Fu sviluppato daKarl Pearsonda un'idea introdotta daFrancis Galtonnel 1880; la formula matematica fu derivata e pubblicata daAuguste Bravaisnel 1844.[2][3][4]La denominazione del coefficiente è anche un esempio dellalegge di Stigler.

Definizione

modificaDate duevariabili statistichee,l'indice di correlazione di Pearson è definito come la lorocovarianzadivisa per il prodotto delledeviazioni standarddelle due variabili:

doveè lacovarianzatraeesono le duedeviazioni standard.

Il coefficiente assume sempre valori compresi trae[5]

Correlazione e indipendenza

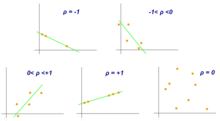

modificaNella pratica si distinguono vari "tipi" di correlazione.

- Se,le variabiliesi diconodirettamente correlate,oppurecorrelate positivamente;

- se,le variabiliesi diconoincorrelate;

- se,le variabiliesi diconoinversamente correlate,oppurecorrelate negativamente.

Inoltre per la correlazione diretta (e analogamente per quella inversa) si distingue:

- sesi hacorrelazione debole;

- sesi hacorrelazione moderata;

- sesi hacorrelazione forte.

Se le due variabili sonoindipendentiallora l'indice di correlazione vale 0. Non vale la conclusione opposta: in altri termini, l'incorrelazione è condizionenecessariama nonsufficienteper l'indipendenza. Per esempio data la distribuzione

| X: | -3 | -2 | -1 | 0 | 1 | 2 | 3 |

|---|---|---|---|---|---|---|---|

| Y: | 9 | 4 | 1 | 0 | 1 | 4 | 9 |

abbiamo cheenon sono indipendenti in quanto legate dalla relazione,ma.

L'ipotesi di assenza diautocorrelazioneè più restrittiva ed implica quella di indipendenza fra due variabili.

L'indice di correlazione valein presenza di correlazione lineare positiva perfetta (cioè,con), mentre valein presenza di correlazione lineare negativa perfetta (cioè,con).

Valori prossimi a(o) possono essere misurati anche in presenza di relazioni non lineari. Per esempio, la seguente relazione quadratica:

| X: | 1 | 2 | 3 | 4 |

|---|---|---|---|---|

| Y: | 1 | 4 | 9 | 16 |

produce un coefficiente.

Generalizzazione a più di due variabili

modificaGli indici di correlazione divariabili possono essere presentati in unamatrice di correlazione,che è unamatrice quadratadi dimensioneavente sia sulle righe che sulle colonne le variabili oggetto di studio. La matrice èsimmetrica,cioè,e i coefficienti sulla diagonale valgonoin quanto

Proprietà matematiche

modificaUn valore dell'indice di correlazione uguale aocorrisponde a punti che si trovano esattamente su una linea retta. Il coefficiente di correlazione di Pearson è simmetrico:

Una proprietà matematica caratteristica del coefficiente di correlazione di Pearson è che non varia rispetto ai cambiamenti singoli della posizione e della scala delle due variabili. Cioè, possiamo trasformareine trasformareindoveesono costanti reali consenza modificare il coefficiente di correlazione.

Esempio in R

modificaUtilizzando illinguaggio di programmazioneRsi vuole calcolare l'indice di correlazione di Pearson tra la variabileFertility rate, total (births per woman)e la variabileGDP per capita (current US$)nel 2020, fornite dalla Banca Mondiale qui:https://databank.worldbank.org/reports.aspx?source=world-development-indicators.Per fare questo si utilizza la funzionecornel seguente modo:

library(dplyr)

World_Bank_Data<-read.csv("World_Bank_Data.csv")

df1<-World_Bank_Data%>%

filter(Series.Name=="Fertility rate, total (births per woman)")%>%

select(Country.Name,X2020..YR2020.)

colnames(df1)[2]<-"Numero di figli per donna"

df2<-World_Bank_Data%>%

filter(Series.Name=="GDP per capita (current US$)")%>%

select(Country.Name,X2020..YR2020.)

colnames(df2)[2]<-"Pil procapite"

df1<-merge(df1,df2,by="Country.Name")

df1$`Numero di figli per donna`<-as.numeric(df1$`Numero di figli per donna`)

df1$`Pil procapite`<-as.numeric(df1$`Pil procapite`)

df1<-df1[-which(is.na(df1$`Pil procapite`)),]

df1<-df1[-which(is.na(df1$`Numero di figli per donna`)),]

cor(df1$`Numero di figli per donna`,df1$`Pil procapite`,)

-0.4601806

Note

modifica- ^abGlossario Istat,suwww3.istat.it(archiviato dall'url originaleil 31 dicembre 2011).

- ^(F. Galton) (24 September 1885), "The British Association: Section II, Anthropology: Opening address by Francis Galton, F.R.S., etc., President of the Anthropological Institute, President of the Section," Nature, 32 (830): 507–510..

- ^Karl Pearson (20 June 1895) "Notes on regression and inheritance in the case of two parents," Proceedings of the Royal Society of London, 58: 240–242..

- ^Stigler, Stephen M. (1989). "Francis Galton's Account of the Invention of Correlation". Statistical Science. 4 (2): 73–79..

- ^Ross,p. 117.

Bibliografia

modifica- Sheldon M. Ross,Introduzione alla statistica,2ª ed., Maggioli Editore, 2014,ISBN 8891602671.

Voci correlate

modifica- Coefficiente di correlazione per ranghi di Spearman

- Coefficiente di correlazione per ranghi di Kendall

- Regressione lineare

- Correlazione (statistica)

- Karl Pearson

- Francis Galton,il primo a introdurre la letterar(come abbreviazione di "regressione" ) anche se utilizzava un coefficiente diverso, in quanto normava usando lo scarto interquartile.

Collegamenti esterni

modifica- (EN) Ken Stewart,Pearson’s correlation coefficient,suEnciclopedia Britannica,Encyclopædia Britannica, Inc.

- (EN) Eric W. Weisstein,Indice di correlazione di Pearson,suMathWorld,Wolfram Research.

| Controllo di autorità | GND(DE)4165345-2 |

|---|