Càng tiểu càng cường đại GPT-4o mini sau lưng, AI mô hình tương lai không hề là càng lớn càng tốt

Thượng chu OpenAI dẫn đầu đêm khuya thả ra đại chiêu, đẩy ra GPT-4o mini trình diễn “Lấy tiểu thắng đại” trò hay, một chân đem GPT-3.5 Turbo đá “Giải nghệ”, thậm chí ở đại mô hình đấu trường LMSYS thượng còn mạnh hơn GPT-4.

Tới rồi bổn chu Meta tuyên bố Llama 3.1 đại mô hình, nếu nói đệ nhất thê đội 405B kích cỡ còn tại dự kiến bên trong, như vậy trình diễn “Lấy tiểu thắng đại” 8B cùng 70B kích cỡ phiên bản tắc mang đến càng nhiều kinh hỉ.

Mà này có lẽ không phải tiểu mô hình cạnh tranh chung điểm, càng có thể là một cái tân khởi điểm.

Không phải đại mô hình dùng không dậy nổi, mà là tiểu mô hình càng có tính giới so

Ở AI vòng diện tích rộng lớn trong thiên địa, tiểu mô hình trước sau trước sau có chính mình truyền thuyết.

Ra bên ngoài xem, năm trước nhất minh kinh nhân Mistral 7B mới vừa một phát bố đã bị dự vì “Tốt nhất 7B mô hình”, ở nhiều hạng đánh giá tiêu chuẩn cơ bản trung đều thắng qua 13B tham số mô hình Llama 2, cũng ở trinh thám, toán học cùng số hiệu sinh thành phương diện siêu việt Llama 34B.

Năm nay hơi mềm cũng khai nguyên mạnh nhất tiểu tham số đại mô hình phi-3-mini, tuy rằng tham số lượng chỉ có 3.8B, nhưng tính năng bình trắc kết quả viễn siêu ngang nhau tham số quy mô trình độ, vượt cấp sánh vai GPT-3.5, Claude-3 Sonnet chờ lớn hơn nữa mô hình.

Hướng nội xem, diện bích trí năng ở 2 đầu tháng đẩy ra chỉ có 2B tham số lượng cấp đoan sườn ngôn ngữ mô hình diện bích MiniCPM, dùng càng tiểu nhân kích cỡ thực hiện càng cường tính năng, tính năng siêu việt nước Pháp đương hồng đại mô hình Mistral-7B, được xưng là “Pháo cỡ nhỏ”.

Trước đó không lâu, chỉ có 8B tham số lớn nhỏ MiniCPM-Llama3-V2.5 ở nhiều mô thái tổng hợp tính năng, OCR năng lực chờ phương diện cũng siêu việt GPT-4V cùng Gemini Pro chờ lớn hơn nữa mô hình, cũng bởi vậy bị Stanford đại học AI đoàn đội sao chép.

Thẳng đến thượng chu, đêm khuya tạc tràng OpenAI đẩy ra bị này miêu tả vì “Công năng mạnh nhất, lời nhất tiểu tham số mô hình” ——GPT-4o mini, lấy mênh mông cuồn cuộn chi thế đem mọi người tầm nhìn kéo về đến tiểu mô hình bên trong.

Từ khi OpenAI đem toàn thế giới túm nhập sinh thành thức AI tưởng tượng tới nay, từ cuốn bề trên bên dưới, đến cuốn tham số, trí năng thể, lại cho tới bây giờ giá cả chiến, trong ngoài nước phát triển trước sau quay chung quanh một cái logic —— thông qua mại hướng thương nghiệp hóa do đó lưu tại bài trên bàn.

Bởi vậy, ở một chúng dư luận giữa sân, nhất dẫn nhân chú mục không gì hơn giảm giá OpenAI tựa hồ cũng muốn nhập cục giá cả chiến.

Khả năng rất nhiều người đối GPT-4o mini giá cả không có quá rõ ràng khái niệm. GPT-4o mini mỗi 100 vạn đưa vào token giá cả vì 15 mỹ phân, mỗi 100 vạn phát ra token giá cả vì 60 mỹ phân, so GPT-3.5 Turbo tiện nghi vượt qua 60%.

Nói cách khác, GPT-4o mini sinh thành một quyển 2500 trang thư, giá cả chỉ cần 60 mỹ phân.

OpenAI CEO Sam Altman cũng ở X thượng không khỏi cảm khái, hai năm trước mạnh nhất mô hình cùng GPT-4o mini so sánh với, không chỉ có tính năng chênh lệch thật lớn, hơn nữa sử dụng phí tổn cao tới hiện tại 100 lần.

Ở đại mô hình giá cả chiến càng thêm kịch liệt đồng thời, một ít hiệu suất cao kinh tế khai nguyên tiểu mô hình cũng càng dễ dàng đã chịu thị trường chú ý, rốt cuộc không phải đại mô hình dùng không dậy nổi, mà là tiểu mô hình càng có tính giới so.

Một phương diện, ở toàn cầu GPU bị bạo mua thậm chí thiếu hóa dưới tình huống, huấn luyện cùng bố trí phí tổn so thấp khai nguyên tiểu mô hình cũng đủ để cho này dần dần chiếm cứ thượng phong.

Tỷ như, diện bích trí năng đẩy ra MiniCPM, bằng vào này nhỏ lại tham số có thể thực hiện trinh thám phí tổn đoạn nhai thức hạ ngã, thậm chí có thể thực hiện CPU trinh thám, chỉ cần một đài máy móc liên tục tham số huấn luyện, một trương hiện tạp tiến hành tham số hơi điều, đồng thời cũng có liên tục cải tiến phí tổn không gian.

Nếu ngươi là thành thục khai phá giả, ngươi thậm chí có thể dùng chính mình dựng tiểu mô hình phương thức đi huấn luyện một cái pháp luật lĩnh vực vuông góc mô hình, này trinh thám phí tổn khả năng chỉ vì sử dụng đại hình mô hình hơi điều một phần ngàn.

Một ít đoan sườn “Tiểu mô hình” ứng dụng rơi xuống đất làm không ít nhà máy hiệu buôn có thể nhìn đến dẫn đầu lợi nhuận ánh rạng đông. Tỷ như diện bích trí năng trợ lực Thâm Quyến khu phố cấp toà án nhân dân thượng tuyến vận hành trí tuệ nhân tạo phụ trợ thẩm phán hệ thống, hướng thị trường chứng minh rồi kỹ thuật giá trị.

Đương nhiên, càng chính xác ra, chúng ta đem bắt đầu nhìn đến biến hóa không phải từ đại mô hình đến tiểu mô hình chuyển biến, mà là từ chỉ một phân loại mô hình chuyển hướng một cái mô hình tổ hợp chuyển biến, mà lựa chọn thích hợp mô hình quyết định bởi với tổ chức cụ thể nhu cầu, nhiệm vụ phức tạp tính cùng nhưng dùng tài nguyên.

Về phương diện khác, tiểu mô hình ở di động thiết bị, khảm nhập thức hệ thống hoặc thấp công hao hoàn cảnh trung càng dễ dàng bố trí cùng tổng thể.

Tiểu mô hình tham số quy mô tương đối nhỏ lại, so sánh với đại hình mô hình, này đối tính toán tài nguyên ( như AI tính lực, nội tồn chờ ) nhu cầu so thấp, có thể ở tài nguyên chịu hạn đoan sườn thiết bị thượng càng lưu sướng mà vận hành. Hơn nữa, đoan sườn thiết bị thông thường đối có thể háo, nóng lên chờ vấn đề có càng vì cực hạn yêu cầu, trải qua đặc biệt thiết kế tiểu mô hình có thể càng tốt mà thích xứng đoan sườn thiết bị hạn chế.

Vinh quang CEO Triệu Minh nói qua, đoan sườn bởi vì AI tính lực vấn đề, tham số khả năng ở 1B đến 10B chi gian, internet đại mô hình vân tính toán năng lực có thể làm được 100-1000 trăm triệu, thậm chí càng cao, loại năng lực này chính là hai người chênh lệch.

Di động là ở một cái rất có hạn không gian nội, đúng không? Nó là ở hữu hạn pin, hữu hạn tán nóng hổi hữu hạn tồn trữ hoàn cảnh hạ duy trì 70 trăm triệu, ngươi liền tưởng tượng một chút trong đó nhiều như vậy ước thúc điều kiện, nó nhất định là khó nhất.

Chúng ta cũng từng bật mí phụ trách vận tác quả táo trí năng phía sau màn công thần, trong đó trải qua hơi điều 3B tiểu mô hình chuyên dụng với trích yếu, trau chuốt chờ nhiệm vụ, ở trải qua thích xứng khí thêm vào sau, năng lực trội hơn Gemma-7B, thích hợp ở di động đầu cuối vận hành. Bao gồm Google cũng kế hoạch trong tương lai mấy tháng nội đổi mới thích hợp di động đầu cuối vận hành 2B phiên bản tiểu mô hình Gemma-2.

Gần nhất, trước OpenAI đại thần Andrej Karpathy cũng đưa ra một cái phán đoán, mô hình kích cỡ cạnh tranh sẽ “Ngược hướng nội cuốn”, không phải càng lúc càng lớn, mà là so với ai khác càng tiểu càng linh hoạt.

Tiểu mô hình dựa vào cái gì lấy tiểu thắng đại

Andrej Karpathy đoán trước đều không phải là bắn tên không đích.

Ở cái này số liệu vì trung tâm thời đại, mô hình đang nhanh chóng trở nên càng thêm khổng lồ cùng phức tạp, trải qua rộng lượng số liệu huấn luyện ra siêu đại mô hình ( như GPT-4 ), đại bộ phận kỳ thật là dùng để nhớ kỹ đại lượng râu ria chi tiết, cũng chính là học bằng cách nhớ tư liệu.

Nhưng mà, trải qua hơi điều mô hình ở riêng nhiệm vụ thượng thậm chí “Lấy tiểu thắng đại”, dùng tốt trình độ so sánh không ít “Siêu đại mô hình”.

Hugging Face CEO Clem Delangue cũng từng kiến nghị, nhiều đạt 99% sử dụng trường hợp có thể thông qua sử dụng tiểu mô hình tới giải quyết, cũng đoán trước 2024 năm sẽ là loại nhỏ ngôn ngữ mô hình một năm.

Cứu này nguyên nhân phía trước, chúng ta đến trước phổ cập khoa học một ít tri thức.

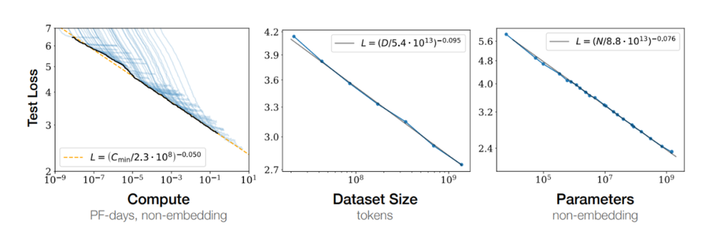

2020 năm, OpenAI ở một thiên luận văn trung đưa ra một cái trứ danh định luật: Scaling law, chỉ chính là theo mô hình lớn nhỏ gia tăng, này tính năng cũng sẽ tùy theo gia tăng. Theo GPT-4 chờ mô hình đẩy ra, Scaling law ưu thế cũng dần dần hiển hiện ra.

AI lĩnh vực nghiên cứu giả cùng kỹ sư tin tưởng vững chắc, thông qua gia tăng mô hình tham số số lượng, có thể tiến thêm một bước tăng lên mô hình học tập năng lực cùng phiếm hóa năng lực. Cứ như vậy, chúng ta chứng kiến mô hình quy mô từ mấy tỷ tham số nhảy thăng đến mấy trăm tỷ, thậm chí hướng tới ngàn tỷ tham số quy mô mô hình trèo lên.

Ở AI trong thế giới, mô hình quy mô đều không phải là cân nhắc này trí năng duy nhất tiêu chuẩn.

Tương phản, một cái tinh xảo thiết kế loại nhỏ mô hình, thông qua ưu hoá thuật toán, tăng lên số liệu chất lượng, chọn dùng tiên tiến áp súc kỹ thuật, thường thường có thể ở riêng nhiệm vụ thượng bày ra ra cùng đại hình mô hình cùng so sánh thậm chí càng ưu tính năng. Loại này lấy vốn nhỏ đánh cuộc to sách lược, chính trở thành AI lĩnh vực tân xu thế.

Trong đó đề cao số liệu chất lượng là tiểu mô hình lấy tiểu thắng đại phương pháp chi nhất.

Coalesce thủ tịch kỹ thuật quan kiêm liên hợp người sáng lập Satish Jayanthi từng như vậy hình dung số liệu đối mô hình tác dụng:

Nếu 17 thế kỷ liền có LLM, mà chúng ta hỏi ChatGPT địa cầu là viên vẫn là bình, nó trả lời nói địa cầu là bình, kia sẽ là bởi vì chúng ta cung cấp số liệu làm nó tin tưởng đây là sự thật. Chúng ta cung cấp cấp LLM số liệu cùng với chúng ta phương thức huấn luyện, đem trực tiếp ảnh hưởng này phát ra.

Vì sản xuất cao chất lượng kết quả, đại hình ngôn ngữ mô hình yêu cầu tiếp thu nhằm vào riêng chủ đề cùng lĩnh vực cao chất lượng, có nhằm vào số liệu huấn luyện. Tựa như học sinh yêu cầu chất lượng tốt giáo tài tới học tập giống nhau, LLM cũng yêu cầu chất lượng tốt số liệu nguyên.

Vứt lại truyền thống mạnh mẽ ra kỳ tích bạo lực mỹ học, đại học Thanh Hoa máy tính hệ trường sính phó giáo sư, diện bích trí năng thủ tịch nhà khoa học Lưu biết xa trước đó không lâu đưa ra đại mô hình thời đại diện bích định luật, tức mô hình tri thức mật độ không ngừng tăng lên, bình quân mỗi 8 tháng tăng lên gấp đôi.

Trong đó tri thức mật độ = mô hình năng lực / tham dự tính toán mô hình tham số.

Lưu biết xa hình tượng mà giải thích nói, nếu cho ngươi 100 nói chỉ số thông minh thí nghiệm đề, ngươi đạt được không chỉ có quyết định bởi với ngươi đáp đúng nhiều ít đề, càng ở chỗ ngươi hoàn thành này đó đề mục sở vận dụng thần kinh nguyên số lượng. Nếu dùng càng thiếu thần kinh nguyên hoàn thành càng nhiều nhiệm vụ, như vậy ngươi chỉ số thông minh liền càng cao.

Đây đúng là tri thức mật độ sở muốn truyền đạt trung tâm lý niệm:

Nó có hai cái yếu tố, một cái yếu tố là cái này mô hình có khả năng đạt thành năng lực. Cái thứ hai yếu tố là năng lực này sở yêu cầu tiêu hao sở yêu cầu thần kinh nguyên số lượng, hoặc là nói đúng ứng tính lực tiêu hao.

So sánh với OpenAI với 2020 năm tuyên bố 1750 trăm triệu tham số GPT-3, 2024 năm diện bích tuyên bố GPT-3 ngang nhau tính năng nhưng tham số chỉ vì 24 trăm triệu MiniCPM -2.4B, tri thức mật độ đề cao đại khái 86 lần.

Hạng nhất đến từ Toronto đại học nghiên cứu cũng cho thấy, đều không phải là sở hữu số liệu đều là tất yếu, từ đại hình số liệu tập trung phân biệt ra cao chất lượng tử tập, này đó tử tập càng dễ dàng xử lý thả bảo lưu lại nguyên thủy số liệu tập trung sở hữu tin tức cùng đa dạng tính.

Cho dù đi trừ cao tới 95% huấn luyện số liệu, mô hình ở riêng phân bố nội đoán trước tính năng cũng có thể sẽ không đã chịu lộ rõ ảnh hưởng.

Sắp tới nhất điển hình ví dụ đương thuộc Meta Llama 3.1 đại mô hình.

Meta ở huấn luyện Llama 3 khi, uy 15T tokens huấn luyện số liệu, nhưng phụ trách Llama2 cùng Llama3 huấn luyện sau công tác Meta AI nghiên cứu viên Thomas Scialom lại tỏ vẻ: Trên mạng văn bản tràn ngập vô dụng tin tức, căn cứ vào này đó tin tức tiến hành huấn luyện là lãng phí tính toán tài nguyên.

“Llama 3 hậu kỳ huấn luyện trung không có bất luận kẻ nào công biên soạn đáp án…… Chỉ là lợi dụng Llama 2 thuần hợp thành số liệu.”

Ngoài ra, tri thức chưng cất cũng là trong đó một cái “Lấy tiểu thắng đại” quan trọng phương pháp.

Tri thức chưng cất chỉ chính là thông qua một cái đại hình thả phức tạp “Giáo viên mô hình” tới chỉ đạo một cái loại nhỏ thả đơn giản “Học sinh mô hình” huấn luyện, có thể đem đại mô hình cường đại tính năng cùng ưu việt phiếm hóa năng lực dời đi cấp càng nhẹ lượng cấp, giải toán phí tổn càng thấp tiểu mô hình.

Ở Llama 3.1 tuyên bố lúc sau, Meta CEO Jack Berg sáng tác một thiên trường văn 《Open Source AI Is the Path Forward》, hắn ở trường văn trung cũng cường điệu nhắc tới hơi điều hòa chưng cất tiểu mô hình tầm quan trọng.

Chúng ta yêu cầu huấn luyện, hơi điều hòa chưng cất chính mình mô hình. Mỗi cái tổ chức đều có bất đồng nhu cầu, này đó nhu cầu tốt nhất thông qua sử dụng bất đồng quy mô cũng sử dụng riêng số liệu huấn luyện hoặc hơi điều mô hình tới thỏa mãn.

Thiết bị thượng nhiệm vụ cùng phân loại nhiệm vụ yêu cầu loại nhỏ mô hình, mà càng phức tạp nhiệm vụ tắc yêu cầu đại hình mô hình.

Hiện tại, ngươi có thể sử dụng tiên tiến nhất Llama mô hình, tiếp tục dùng chính mình số liệu huấn luyện chúng nó, sau đó đem chúng nó chưng cất thành nhất thích hợp ngươi nhu cầu mô hình quy mô —— không cần chúng ta hoặc bất luận cái gì những người khác nhìn đến ngươi số liệu.

Trong nghề cũng phổ biến cho rằng, Meta Llama 3.1 8B cùng 70B phiên bản là từ siêu bát lớn chưng cất mà thành, bởi vậy, chỉnh thể tính năng được đến lộ rõ quá độ, mô hình hiệu suất cũng càng cao.

Lại hoặc là, mô hình giá cấu ưu hoá cũng là mấu chốt, tỷ như MobileNet thiết kế ước nguyện ban đầu là ở di động thiết bị thượng thực hiện hiệu suất cao chiều sâu học tập mô hình.

Nó thông qua chiều sâu nhưng chia lìa cuốn tích ( Depthwise Separable Convolution ) lộ rõ giảm bớt mô hình tham số số lượng. MobileNetV1 so với ResNet ở tham số số lượng thượng giảm bớt ước 8-9 lần.

Bởi vì tham số số lượng giảm bớt, MobileNet ở tính toán thượng càng vì hiệu suất cao. Này đối với tài nguyên chịu hạn hoàn cảnh ( như di động thiết bị ) đặc biệt quan trọng, bởi vì nó có thể ở không hy sinh quá nhiều tính năng dưới tình huống, lộ rõ hạ thấp tính toán cùng tồn trữ nhu cầu.

Cứ việc kỹ thuật mặt lấy được tiến bộ, nhưng AI ngành sản xuất bản thân vẫn gặp phải trường chu kỳ đầu nhập cùng cao phí tổn khiêu chiến, thả hồi báo chu kỳ tương đối so trường.

Theo 《 mỗi ngày kinh tế tin tức 》 không hoàn toàn thống kê, tính đến năm nay 4 cuối tháng, quốc nội cộng đẩy ra ước 305 cái đại mô hình, nhưng tính đến 5 nguyệt 16 ngày, còn có ước 165 cái đại mô hình chưa hoàn thành lập hồ sơ.

Baidu người sáng lập Lý Ngạn hoành từng công khai phê bình, cho rằng trước mặt đông đảo cơ sở mô hình tồn tại là đối tài nguyên lãng phí, cũng kiến nghị ứng đem tài nguyên càng nhiều mà dùng cho thăm dò mô hình cùng ngành sản xuất kết hợp khả năng tính, cùng với khai phá tiếp theo cái tiềm tàng siêu cấp ứng dụng.

Đây cũng là trước mặt AI ngành sản xuất một cái trung tâm vấn đề, mô hình số lượng tăng vọt cùng thực tế ứng dụng rơi xuống đất chi gian không tương xứng mâu thuẫn.

Đối mặt này một khiêu chiến, ngành sản xuất tiêu điểm dần dần chuyển hướng gia tốc AI kỹ thuật rơi xuống đất ứng dụng, mà bố trí phí tổn thấp cùng hiệu suất càng cao tiểu mô hình thành càng vì thích hợp phá cục điểm.

Cho nên chúng ta chú ý tới một ít chuyên chú với riêng lĩnh vực loại nhỏ mô hình bắt đầu toát ra tới, tỷ như nấu nướng đại mô hình, phát sóng trực tiếp mang hóa đại mô hình. Này đó tên tuổi tuy rằng thoạt nhìn có chút hù người, nhưng vừa lúc là đi ở chính xác trên đường.

Nói tóm lại, tương lai AI đem không hề là chỉ một, khổng lồ tồn tại, mà là sẽ càng thêm đa dạng hóa, cá tính hóa. Tiểu mô hình quật khởi, đúng là này một xu thế thể hiện. Chúng nó ở riêng nhiệm vụ thượng bày ra ra trác tuyệt tính năng, chứng minh rồi “Tiểu mà mỹ” đồng dạng có thể thắng được tôn trọng cùng tán thành.

One more Thing

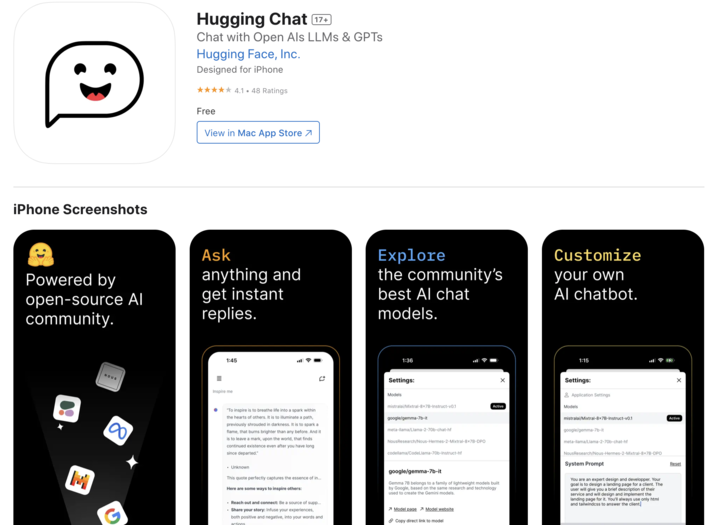

Nếu ngươi tưởng ở iPhone nâng lên trước chạy mô hình, kia không ngại nếm thử Hugging Face đẩy ra một khoản tên là “Hugging Chat” iOS App.

Mượn dùng ma pháp tốt đẹp khu App Store tài khoản có thể download nên App, sau đó người dùng có thể ở phỏng vấn cùng sử dụng các loại khai nguyên mô hình, bao gồm nhưng không giới hạn trong Phi 3,

Mixtral, Command R+ chờ mô hình.

Ấm áp nhắc nhở, vì đạt được càng giai thể nghiệm cùng tính năng, kiến nghị sử dụng mới nhất một thế hệ Pro bản iPhone.

Download liên tiếp: https://apps.apple /us/app/huggingchat/id6476778843