启动Docker服务

systemctl enable docker

systemctl start docker

systemctl status docker

三、创建hadoop容器

宿主机环境准备

拉取镜像

docker pull centos:7

进入存放安装包目录

cd /mnt/docker_share

上传jdk和hadoop

- 前提:安装上传软件工具(yum install lrzsz)

rz jdk*.tar.gz;rz hadoop*.tar.gz

解压软件包

- 解压到opt目录,后续我们将映射该目录下的软件包到docker容器

tar -xvzf jdk-8u141-linux-x64.tar.gz -C /opt

tar -xvzf hadoop-2.7.0.tar.gz -C /opt

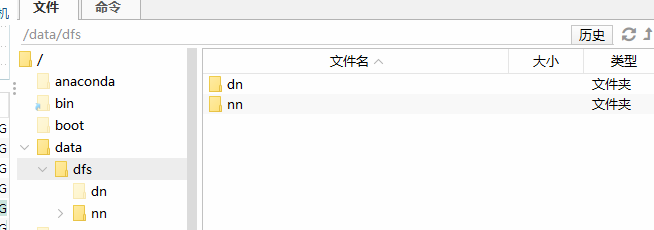

创建用于保存数据的文件夹

mkdir -p /data/dfs/nn

mkdir -p /data/dfs/dn

容器环境准备

启动hadoop容器

- 注意一定要添加 --privileged=true,否则无法使用系统服务

docker run \

--net docker-bd0 --ip 172.33.0.121 \

-p 50070:50070 -p 8088:8088 -p 19888:19888 \

-v /mnt/docker_share:/mnt/docker_share \

-v /etc/hosts:/etc/hosts \

-v /opt/hadoop-2.7.0:/opt/hadoop-2.7.0 \

-v /opt/jdk1.8.0_141:/opt/jdk1.8.0_141 \

-v /data/dfs:/data/dfs \

--privileged=true \

-d -it --name hadoop centos:7 \

/usr/sbin/init

注意:确保在主机上禁用SELinux

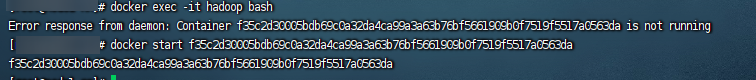

进入hadoop容器

docker exec -it hadoop bash

安装vim

- 为了后续方便编辑配置文件,安装一个vim

yum install -y vim

安装ssh

- 因为启动Hadoop集群需要进行免密登录,Centos7容器需要安装ssh

yum install -y openssl openssh-server

yum install -y openssh-client*

- 修改ssh配置文件

vim /etc/ssh/sshd_config

# 在文件最后添加

PermitRootLogin yes

RSAAuthentication yes

PubkeyAuthentication yes

- 启动ssh服务

systemctl start sshd.service

# 设置开机自动启动ssh服务

systemctl enable sshd.service

# 查看服务状态

systemctl status sshd.service

配置免密登录

生成秘钥

ssh-keygen

设置密码

- 设置root用户的密码为123456

passwd

拷贝公钥

ssh-copy-id hadoop.bigdata.cn

测试免密登录

ssh hadoop.bigdata.cn

配置JDK

vim /etc/profile

# 配置jdk的环境变量

export JAVA\_HOME=/opt/jdk1.8.0_141

export CLASSPATH=${JAVA\_HOME}/lib

export PATH=${JAVA\_HOME}/bin:$PATH

# 让上一步配置生效

source /etc/profile

配置Hadoop

- core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop.bigdata.cn:9000</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

<property>

<name>hadoop.http.staticuser.user</name>

<value>root</value>

</property>

- hdfs-site.xml

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop.bigdata.cn:50070</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop.bigdata.cn:50090</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///data/dfs/nn</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///data/dfs/dn</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

- yarn-site.xml

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop-yarn</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop.bigdata.cn</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<property>

<name>yarn.nodemanager.remote-app-log-dir</name>

<value>/user/container/logs</value>

</property>

- mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop.bigdata.cn:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop.bigdata.cn:19888</value>

</property>

<property>

<name>mapreduce.jobhistory.intermediate-done-dir</name>

<value>/tmp/mr-history</value>

</property>

<property>

<name>mapreduce.jobhistory.done-dir</name>

<value>/tmp/mr-done</value>

</property>

- hadoop-env.sh

export JAVA\_HOME=/opt/jdk1.8.0_141

- slaves

hadoop.bigdata.cn

-

配置环境变量

- vim /etc/profile

- source /etc/profile

export HADOOP\_HOME=/opt/hadoop-2.7.0

export PATH=${HADOOP\_HOME}/sbin:${HADOOP\_HOME}/bin:$PATH

四、初始化并启动Hadoop

格式化hdfs

hdfs namenode -format

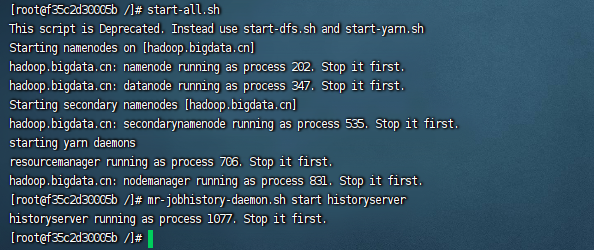

启动hadoop

start-all.sh

# 启动history server

mr-jobhistory-daemon.sh start historyserver

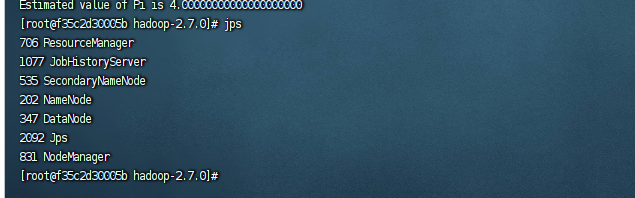

测试hadoop

cd $HADOOP\_HOME

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.0.jar pi 2 1

image-20230918194247221

查看进程

bash-4.1# jps

561 ResourceManager

659 NodeManager

2019 Jps

1559 NameNode

1752 SecondaryNameNode

249 DataNode

五、配置开启容器启动Hadoop

创建启动脚本

- 创建新文件存放启动脚本

touch /etc/bootstrap.sh

chmod a+x /etc/bootstrap.sh

vim /etc/bootstrap.sh

- 文件内容

#!/bin/bash

source /etc/profile

cd /opt/hadoop-2.7.0

start-dfs.sh

start-yarn.sh

mr-jobhistory-daemon.sh start historyserver

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

opt/hadoop-2.7.0

start-dfs.sh

start-yarn.sh

mr-jobhistory-daemon.sh start historyserver

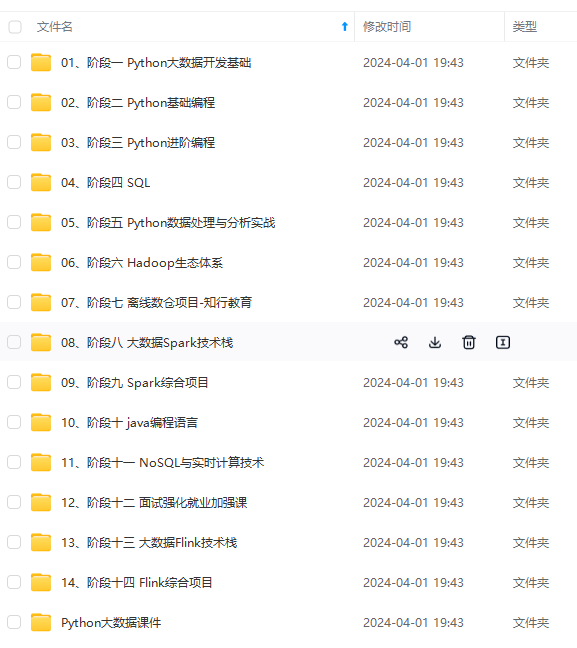

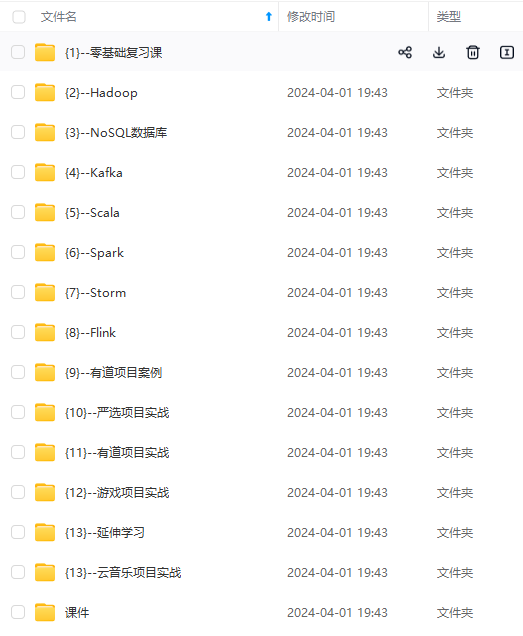

[外链图片转存中...(img-8uubqP00-1714647910984)]

[外链图片转存中...(img-qC2gZwYg-1714647910985)]

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

5061

5061