Real-Time Analytics with Spark Streaming

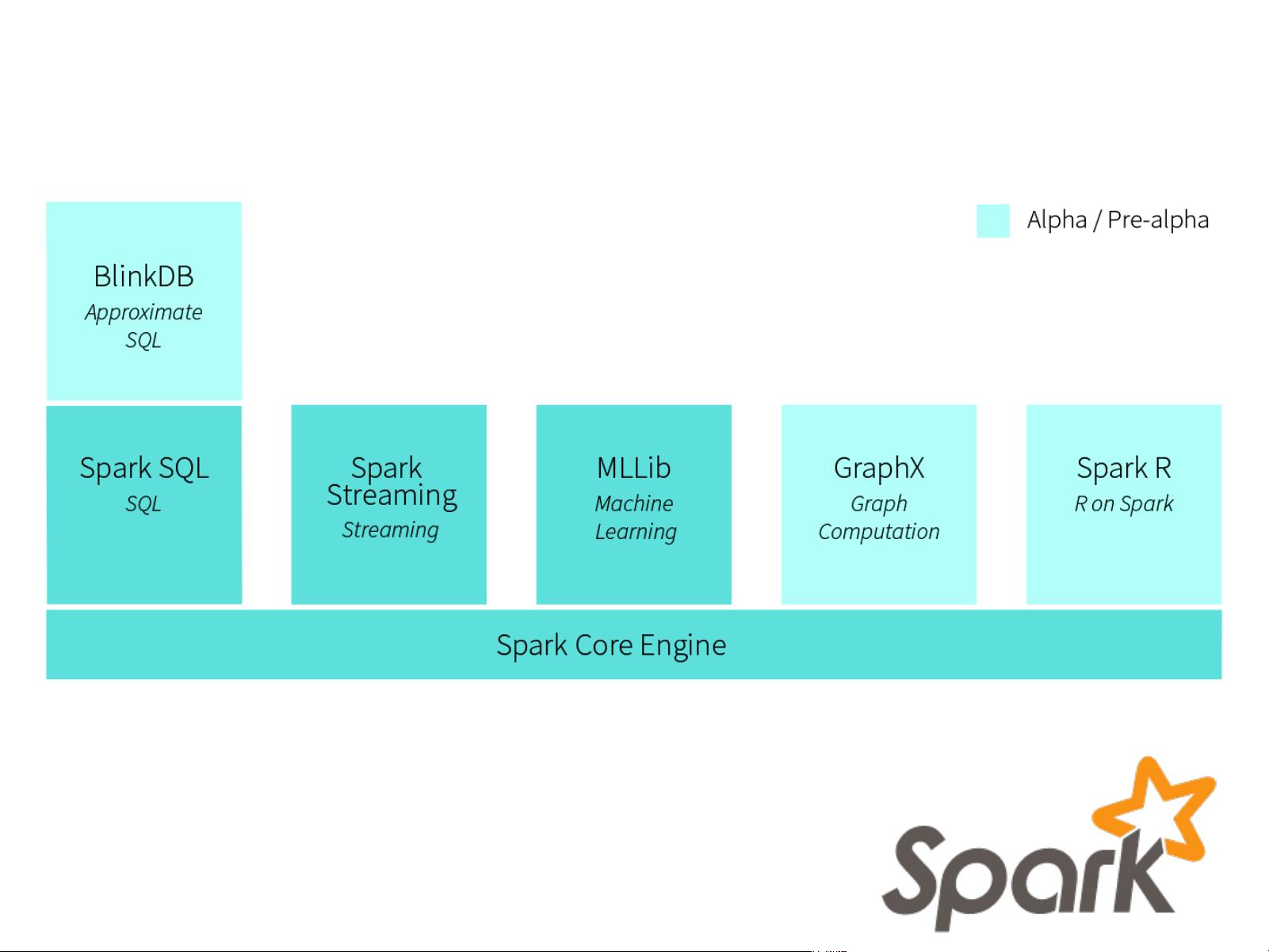

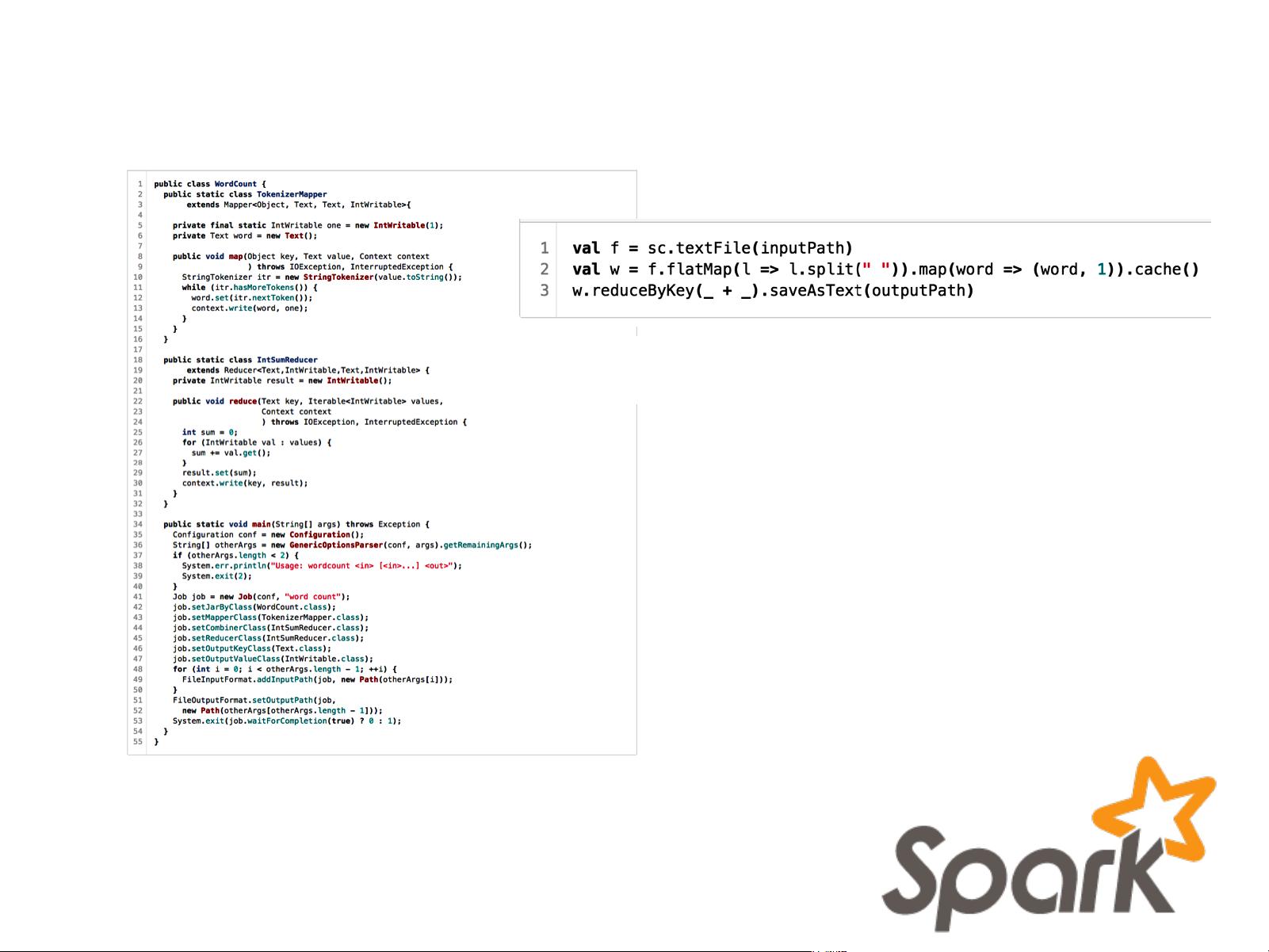

标题和描述中提到的知识点为:Real-Time Analytics with Spark Streaming,这是一种实时的分析技术,使用了Apache Spark这个开源的海量数据处理框架。Spark Streaming是Spark的一部分,它可以将实时数据流作为输入,进行处理,然后输出结果。 Apache Spark是由加州大学伯克利分校的AMPLab在2009年开发的,2010年开源。它已经成为大数据领域最大的开源社区之一,拥有来自50多个组织的200多名贡献者。Spark在内存性能上表现出色,支持迭代模型,适合机器学习和图分析等高级分析解决方案。因此,对于那些面临大数据挑战的企业,包括数据收集、ETL、存储、探索和分析等,应该考虑使用Spark。 Spark的核心概念包括弹性分布式数据集(RDDs),这是分布式内存的一个抽象,可以进行容错、并行操作。RDDs可以由外部数据集创建,也可以通过在其他RDDs上进行转换(如map、filter、join、reduce)而创建。另外,Spark支持多种编程语言,包括Scala、Java、Python和R,可以运行在Hadoop、Mesos、独立的部署模式或云上。 Streaming Analytics是Spark Streaming的基础,它是对实时数据流进行分析的过程。在早期的应用场景中,主要包括金融、广告、安全和电信等领域。这些应用场景通常具有相似的风险/回报比。而现在,Spark Streaming的应用场景正在扩展到基因组学、交通、医疗保健、工业物联网、地理空间分析、数据中心运营、教育、视频转码等领域。 Spark Streaming的设计目标是通过提供容错、低延迟处理、高吞吐量的实时数据流处理能力,使用户能够在数据到达时立即分析数据,而不需要等待大量数据的批处理。Spark Streaming可以和现有的大数据集群集成,但不需要单独为实时分析维护一个巨大的集群。 Spark Streaming是基于微批处理模型构建的,它将数据流分割成一系列小批次,然后使用Spark引擎处理每个小批次的数据。这种方法结合了批处理和流处理的优点,能够达到高吞吐量和低延迟。另外,Spark Streaming还提供了一个高级抽象,称为离散流(DStream),这是连续数据流的一系列微批次的表示。DStream可以通过原始数据流创建,也可以通过其他DStreams转换而来。 Spark Streaming是Apache Spark生态系统的一个重要组成部分,它为实时数据流处理提供了一个强大、高效、容错的处理平台。随着实时分析需求的增长,Spark Streaming在处理大规模、高速的数据流中的作用变得越来越重要。

剩余69页未读,继续阅读

- 粉丝: 166

- 资源: 1772

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功