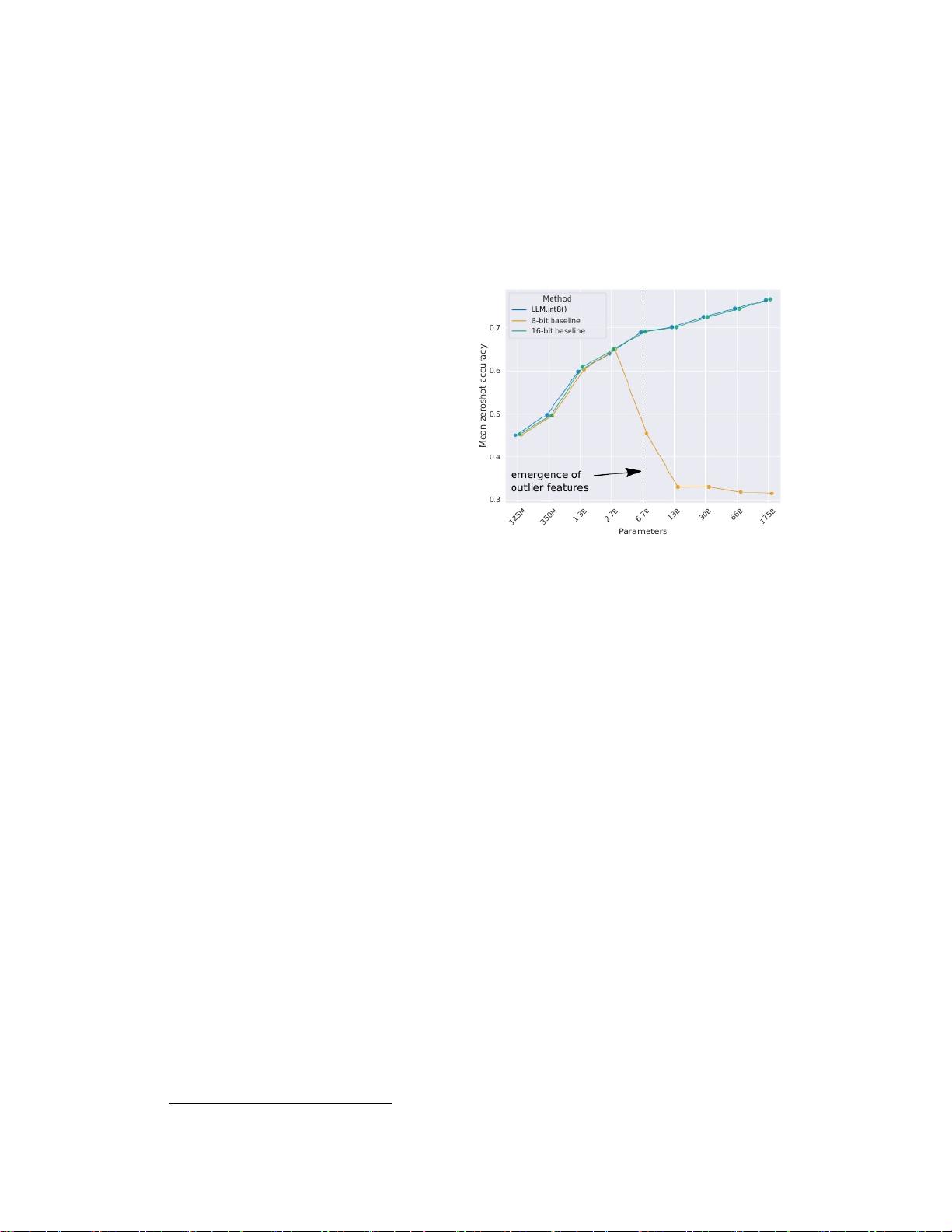

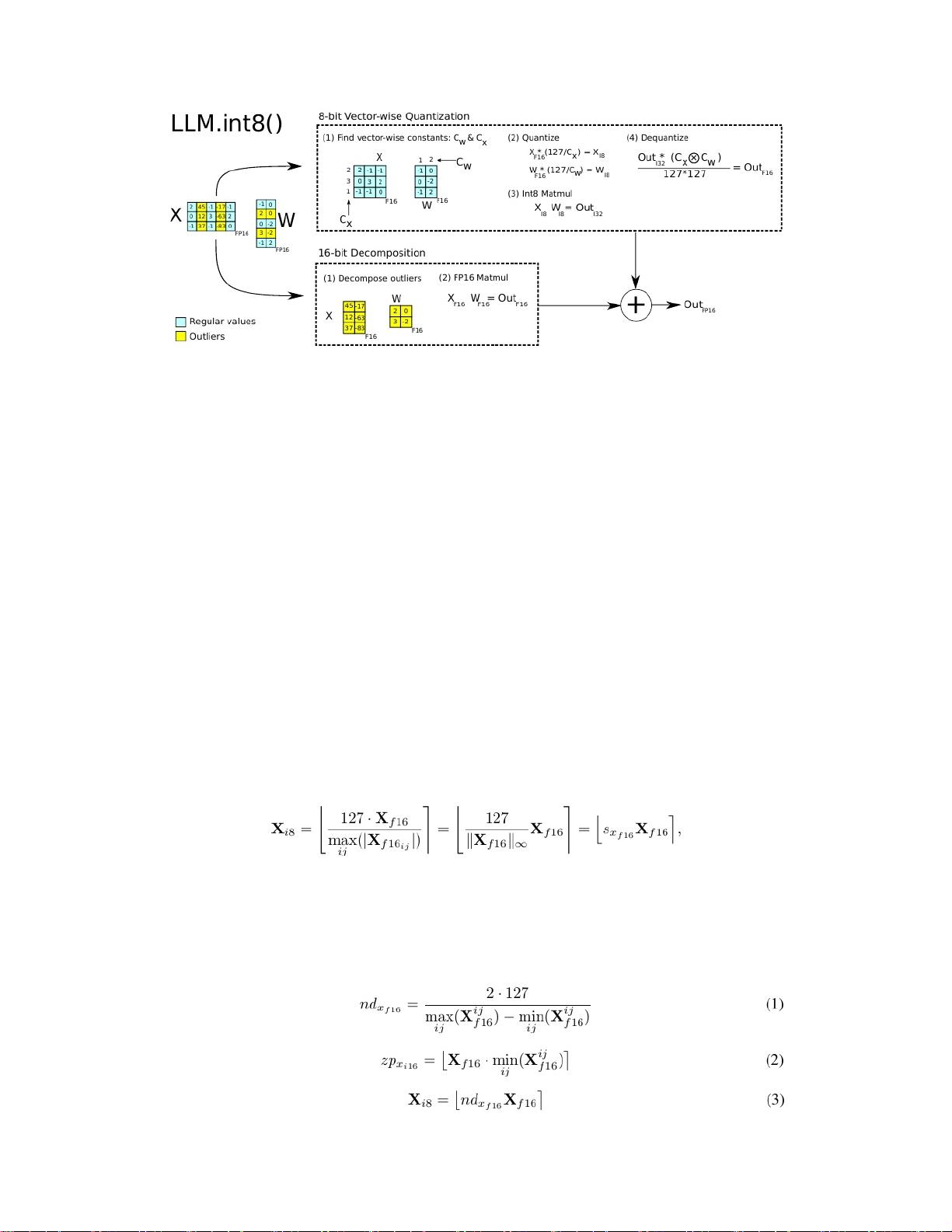

### 巨型语言模型的 8 位量化:LLM.int8() #### 概述 随着深度学习技术的发展,特别是自然语言处理(NLP)领域内的进步,大型语言模型(LLM)已成为人工智能领域的核心组成部分。然而,这些模型通常需要庞大的计算资源,特别是在GPU内存方面。针对这一挑战,《LLM.int8(): 8-bit Matrix Multiplication for Transformers at Scale》这篇论文提出了一种名为LLM.int8()的方法,能够有效地减少大型语言模型在推理过程中的内存占用,而不会牺牲模型的准确性。 #### 关键知识点详解 ##### 1. **背景与动机** 大型语言模型(如Transformer架构)的成功极大地推动了NLP领域的发展,但在实际应用中面临的主要挑战之一是其高内存需求。对于拥有超过6.7亿参数的模型而言,前馈层和注意力层占据了模型总参数量的95%,并且占用了大多数的计算资源(65%-85%)。为了缓解这一问题,研究人员开始探索量化技术,即使用较少的位数来表示权重,从而减少模型的存储需求和加速推理过程。 ##### 2. **现有技术的局限性** 尽管之前已经有一些针对小型模型(小于3.5亿参数)的量化技术,但这些技术往往会导致模型性能下降,并且通常需要额外的微调步骤。更重要的是,这些技术在处理更大规模的模型时效果不佳,尤其是在处理数十亿参数级别的模型时,几乎没有任何已知的有效量化方法。 ##### 3. **LLM.int8() 方法概述** 《LLM.int8()》论文提出了一种创新的量化方法,能够处理数十亿参数级别的大型语言模型,并且不会导致性能下降。该方法的关键在于处理Transformer语言模型中高度系统化的涌现特征,这些特征主导着注意力机制和模型预测性能。 - **矢量量化**:对于矩阵乘法中的每个内积,使用单独的归一化常数来进行量化。这种方法提高了量化精度,并且可以保持良好的性能直到模型参数规模达到2.7亿。 - **混合精度分解**:对于那些极端异常值,引入了一种新的混合精度分解方案。这种方法将异常值特征维度隔离到一个16位的矩阵乘法中,而大部分其他计算仍然可以在8位精度下完成,这保证了超过99.9%的计算依然在8位精度下执行。 ##### 4. **实验结果与分析** 作者展示了他们的方法在多个基准测试上的表现,包括WinoGrande、HellaSwag、PIQA和LAMBADA等数据集上的零样本精度。实验结果显示,使用LLM.int8()方法对具有175亿参数的模型进行量化后,推理过程中的性能没有出现下降。这意味着即使是在消费者级别的GPU上,也可以轻松地部署和运行这类大型语言模型,显著降低了访问这些模型的技术门槛。 ##### 5. **结论与展望** 该论文提出的LLM.int8()方法为大型语言模型的高效部署提供了一种切实可行的解决方案。通过有效处理模型中的高度系统化的涌现特征,并采用矢量量化和混合精度分解技术,这种方法能够在不牺牲模型性能的前提下显著减少模型的内存占用。未来的研究方向可能包括进一步优化量化方法以适应更大的模型规模,以及探索更多类型的模型和任务场景下的应用。 《LLM.int8(): 8-bit Matrix Multiplication for Transformers at Scale》这篇论文通过创新性的量化技术解决了大型语言模型在推理过程中面临的内存挑战,为NLP领域的发展带来了重要的进展。

剩余19页未读,继续阅读

- 粉丝: 1w+

- 资源: 6

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功